A mesterséges intelligencia kapcsán már elég sok témát érintettünk már. Akár az általános felhasználást, akár a magyarországi projekteket nézzük, van egy olyan szempont, ami talán mindennél fontosabb – ez pedig a biztonság kérdése!

Rohamos ütemben fejlődik a mesterséges intelligencia felhasználása. Mindennapi életünk során már szinte kikerülhetetlen lett az elmúlt években. Felelősségteljes fejlesztése és használata a Bosch számára különösen fontos, ezért is szeretjük biztonságban tudni például a tanulásra képes algoritmusokat.

A MI biztonságáról nekünk embereknek kell gondoskodnunk

Kritikus döntési helyzetek

Bár a technológiának számos előnye van, használata kétségkívül kockázatokat rejt magában. Vegyünk például egy olyan tanulásra képes algoritmust, ami egy önvezető járműben dolgozik és az objektumok észlelése és azonosítása a feladata. Mivel ez egy kritikus döntési szituáció, elengedhetetlen, hogy a kritikus döntés egy biztonságos mechanizmus segítségével szülessen meg. Ennek szavatolása azonban kihívásokkal jár.

Egy önvezető autóban dolgozó algoritmus biztonsága különösen fontos lehet a jövőben

Először is meg kell határoznunk, mi minősül biztonságos viselkedésnek az adott algoritmus esetében. Ez tulajdonképpen azt jelenti, hogy deklarálnunk kell, milyen feltételek mellett, milyen szolgáltatásra számíthatunk tőle. Ha ez megvan, biztosítanunk kell, hogy az algoritmus viselkedése minden esetben ennek megfelelő, vagyis biztonságos legyen. Ezzel a metodikával már más, tanulásra nem képes rendszerek esetében is találkozhattunk, de akkor mi az újdonság?

Ugyanaz és mégis más

Mesterséges intelligencia algoritmusokat leginkább összetett, bonyolult feladatokhoz használunk, így a működésüket szinte lehetetlen pontosan specifikálni. Már csak azért is, mert a titka éppen az, hogy a rendelkezésre álló adatokból önállóan tanulja meg a szükséges viselkedést, működést. Járművezetés során pedig még az ember is gyakran hibázik, így nem meglepő, ha kedvezőtlen körülmények között egy algoritmus is hibára késztethető. Csakhogy vele szemben egészen más az elvárás, hiszen tőle mindenki azt várja, hogy hibamenetesen üzemeljen.

Sokszor nehéz a pontos specifikáció a működést illetően

A biztonság garantálásának tehát magában kell foglalnia az algoritmus funkcionális hiányosságainak és akár a hiányzó adatok kezelésének képességét. Ezen a ponton elmerülhetnénk a strukturált gépi tanulási függvények világában, ám e helyett azt javasoljuk, hogy nézzük meg, mit jelent mindez a napi felhasználás szemszögéből.

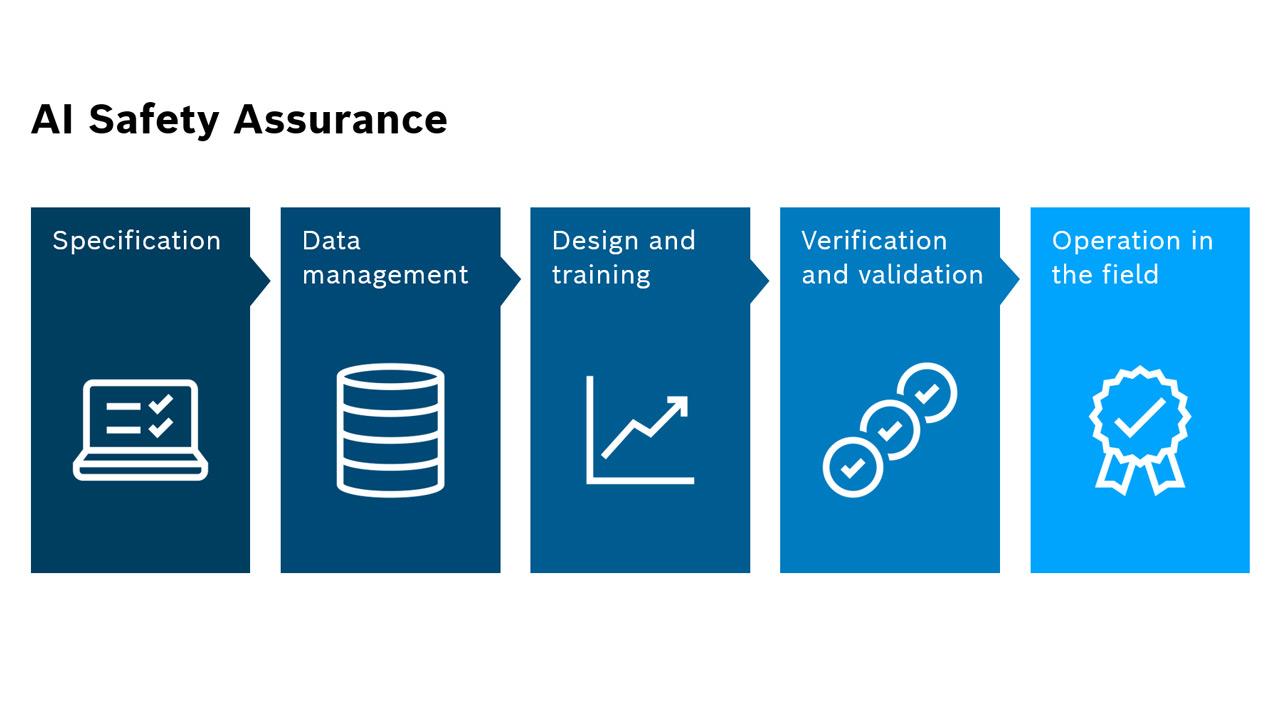

Az MI életciklusának öt fázisa

A korábban már említett automatizált vezetéshez használt neurális hálózatok az objektumészlelés és elemzés kapcsán kapnak fontos szerepet. Kulcsfontosságú feladatuk például a gyalogosok észlelése és a viselkedésük elemzése a sérülések elkerülése érdekében. Az algoritmusok fejlesztése során öt különböző fázist különböztetünk meg.

- Specifikáció

- Adatmenedzsment

- Dizájn és tréning

- Ellenőrzés és érvényesítés

- Művelet a terepen

A specifikációs szakaszban felállítunk egy követelményrendszert. Az ebben foglaltakat használjuk fel a fejlesztés későbbi fázisai során, így pontosítva az algoritmus tevékenységeit. Fontos és egyáltalán nem egyszerű feladat: ezeket a követelményeket nemcsak a funkciók, hanem az adatok kapcsán is meg kell fogalmaznunk. A működésbeli problémák egyik leggyakoribb oka, hogy a tanítási folyamat során nem megfelelő minőségű, és/vagy mennyiségű adatot biztosítunk a rendszernek. Ebben az esetben például olyan hibát okozhat ez, hogy a mesterséges intelligencia nem tud majd különbséget tenni egy egyhelyben álló gyalogos és egy fa törzse között. Nagyon fontos tehát olyan adatokat is biztosítanunk, amelyek látszólag nem tesznek hozzá a funkcionalitáshoz, mégis segíthetnek egy ilyen döntésben. Nem elég magát a neurális hálózatot biztosítani, az adatokat is folyamatosan optimalizálnunk kell.

Kis fejlesztés, nagy eredmény

A legtöbb esetben a hatékonyság növelése a cél, ehhez azonban egy bizonyos szint fölött az emberi elme már kevés lehet

A neurális hálózatok tervezése és fejlesztése esetében a cél a legtöbb esetben az, hogy javítsunk egy folyamat hatékonyságán. A biztonság kapcsán azonban nem lehet kompromisszumokat kötni, a meghatározott követelményeket teljesítenie kell az ilyen rendszereknek. A teljesítmény és a robusztusság alapvető elvárás, ahogy a biztonság is. Ezek pedig csak úgy állhatnak össze, hogy a fejlesztés során a megértjük, hogy mely intézkedéseknek köszönhetően jutunk hozzá az elvárt tulajdonságokhoz és a projektben résztvevők megértik a döntések hátterét.

Fontos, hogy megértsük a döntések hátterét

De még ezek után sem szabad megfeledkeznünk arról, hogy a rendelkezésre álló adatok, csak a valóság egy részhalmazát jelentik. Az ellenőrzés és érvényesítés során ezt mindig szem előtt kell tartanunk. Mindez már csak azért is fontos, mert az adott funkcióknak a beágyazott környezetben, korlátozott erőforrások mellett is megfelelően kell működniük.

A hibákat kezelnünk kell, különben összeomlik a komplex rendszer

Ha pedig mégis működési hibával szembesül a komplex rendszer, azt is kezelni kell. A legrosszabb ugyanis ami történhet, hogy a teljes rendszer összeomlik. A fejlesztés során még a terheléses támadásokra is készülünk, ezzel is biztosítva a korábban már említett robusztusságot.

Akkor is fejlődik, ha már készen van

A termékfejlesztés ezeknél a rendszereknél nem ér véget a publikálás időpontjában. Folyamatos felügyeletet és ellenőrzést igényel a valós működési környezetében is. Fontos, hogy csak akkor fogjunk működésre ilyen komplex megoldásokat, ha már minden erősségét és gyengeségét látjuk és tisztában vagyunk a rendszerben fennmaradó kockázat mértékével. Ennek elfogadhatóan csekélynek kell lennie, máskülönben nem nevezhetjük biztonságosnak a mesterséges intelligenciát. Mivel ez még mindig magában foglalja a fejlesztő és gyártó felelősségét, iparági konszenzusra van szükség. Több olyan együttműködés is előrehaladott állapotban van már, ami biztosítékot jelenthet a későbbieben a felhasználók számára. Tekinthetünk erre egyfajta szabványrendszerként is.

Fontos, hogy termékfejlesztés nem ér véget a publikálás időpontjában, hiszen ezt követően is folyamatos felügyeletet követel a rendszer

A mesterséges intelligencia biztonsága olyan terület, ahol nem köthetünk kompromisszumokat. A Bosch mérnökei hisznek abban, hogy ez az ötfázisú megközelítés – amely figyelembe veszi az életciklus minden szakaszát – megfelelően azonosítja az okokat, amelyek működési zavarokat okozhatnak. Így pedig már könnyebb helyzetben vagyunk a megelőzést illetően is.