Hol húzódnak az etikai határvonalak?

Amikor az Amazon emberi erőforrásokat menedzselő részlege ráébredt, hogy az általuk használt, gépi tanuló algoritmus bizonyos pozíciók kiválasztásakor előnyben részesíti a férfiakat a nőkkel szemben, felfüggesztette a szoftver használatát. Hogyan válnak a logikus, racionális és érzelemmentes alapon döntést hozó algoritmusok diszkriminatívvá? Megnéztük, milyen etikai problémák merülhetnek fel a mesterséges intelligencia fejlesztése kapcsán és mit tehetünk ellene.

Érzéketlen algoritmusok és félrement gépi tanulás

Az úgynevezett gépi tanulással fejlődő algoritmusok a „szűk” mesterséges intelligencia (narrow artificial intelligence – ANI) elérését célozzák. A leghatékonyabban a gépi látás (machine vision) és a természetes nyelvfeldolgozás (natural language processing) terén működnek. Előbbi képek, utóbbi szövegek feldolgozását jelenti. Hogyan működik a gépi tanulás? Vegyünk egy egyszerű példát! Azt szeretnénk, ha az algoritmus megfelelő gépi tanulással felismerné a macskás képeket. Ebben az esetben rengeteg, „macska” feliratú címkével ellátott ábrát kell betáplálni a programba, amely alapján az „megtanulja” a cicát ábrázoló kép jellemzőit. Egyáltalán nem mindegy azonban, hogy milyen mennyiségű és típusú adatokon gyakorol az algoritmus, ahogy az sem: kik, milyen paraméterekkel programozzák a szoftvereket, és a későbbiekben hogyan használják azokat.

A „szűk” mesterséges intelligencia fejlesztésével próbálkozó cégek beleütköztek már abba a problémába, hogy a gépi tanulással dolgozó szoftverek hajlamosak a megkülönböztetésre: diszkriminálják a nőket, a kisebbségeket és más csoportokat, ami a társadalomban meglévő különbségek mélyítéséhez vezethet. Például az amerikai büntetésvégrehajtási rendszerben alkalmazott algoritmus – amelyet arra használtak, hogy az adatok alapján becsülje meg a visszaeső bűnözés valószínűségét egyes esetekben – aránytalanul nagyobb számban sugallta afroamerikai bűnelkövetők visszaesését.

Az Amazon fent említett, munkaerő-kiválasztásra specializálódott programja esetében például tízévnyi szakmai önéletrajzon tanították meg az algoritmusnak, kik lesznek a legjobb jelöltek egy-egy szoftverfejlesztői pozícióra. Azzal azonban nem számoltak, hogy mivel a technológiai ágazatban jobbára a férfiak dominálnak, egy idő után az algoritmus magától úgy véli majd, hogy mivel historikusan az adatok a férfiaknak kedveznek, egyszerűbbé, gyorsabbá és hatékonyabbá válik a folyamat, ha egyszerűen kizárja abból a nőket.

A programozók megpróbálták az algoritmust úgy módosítani, hogy kiiktassák ezt a problémát, nem sikerült, úgyhogy inkább az egész program ment a kukába.

YouTube és összeesküvéselméletek

Hasonlóan problémás eredményeket okoz a YouTube videókat ajánló algoritmusa, amely az aktuálisan nézett videóhoz valahogyan kapcsolódó felvételeket javasol. A szoftver alapvető célja, hogy a látogató minél több időt töltsön el a platformon. Egy idő után a YouTube algoritmusa pedig arra ébredt rá, hogy a felhasználók rengeteget időznek szenzációhajhász magyarázatok és hihetetlen történetek fogyasztásával, így aztán sokkal többször kezdett el ilyen típusú videókat ajánlani.

Mivel a YouTube forgalmának több mint 70 százaléka az ajánlott tartalmakból származik, az algoritmusok választása jelentősen megnövelte az álhírek és összeesküvés-elméletek, például a rákot gyógyító csodaszerekről szóló információk, a laposföld-hívők vagy az oltásellenesek tanainak terjedését. Ez pedig politikai indulatok felkorbácsolásához és az oltásellenes mozgalom növekedésével még egészségügyi problémákhoz is vezetett. A YouTube algoritmusának működésmódja óriási felháborodást keltett, amire válaszul a techvállalat elkezdte felkutatni és törölni a problémás videókat.

A cég azt is lehetővé tette, hogy a nézők megjelöljék a számukra aggályos tartalmakat.

Hogyan építsünk a társadalomra érzékeny mesterséges intelligenciát?

A mesterséges intelligencia fejlesztését célzó, összes vállalat találkozik efféle etikai problémákkal, mivel ez a terület még nagyon gyerekcipőben jár, és nehezen tudják előre felmérni a technológiafejlesztéssel járó társadalmi hatásokat.

Miközben az MI elképesztő eredményeket képes produkálni az egészségügy, a mezőgazdaság, a gépipar vagy éppen a közlekedés terén – gondoljunk csak a diagnosztikai algoritmusokra, amelyek a radiológusokéhoz hasonló eredményeket érnek el a röntgenképek olvasásakor és a tumorok diagnosztizálásakor -, a negatív hatások kétséget és bizalmatlanságot ébreszthetnek az emberekben: ha ilyen társadalmi következményekkel járnak, akkor vajon érdemes-e tanuló algoritmusokat alkalmazni.

Több szervezethez hasonlóan a Bosch is arra az álláspontra helyezkedik, hogy a mesterséges intelligencia számos előnnyel jár, azonban fejlesztésekor és használatakor érdemes leszögezni azokat az elveket és etikai szabályokat, amelyek mentén elkerülhetővé válnak a káros társadalmi hatások és növelhető a technológia iránti bizalom. Az elsőszámú és legfontosabb alapelv, hogy az MI-t mindig az emberek ellenőrzik.

”A mesterséges intelligenciának az embereket kell szolgálnia. MI etikai kódexünk egyértelmű iránymutatást ad munkatársainknak az intelligens termékek fejlesztése során. Az a célunk, hogy az emberek megbízzanak MI-alapú termékeinkben.

Volkmar Denner,a Bosch igazgatótanácsának elnöke

Emberközpontú mesterséges intelligencia

Az etikai kódex három lehetséges megközelítést kínál a mesterséges intelligencia emberközpontú használatára.

Human-in-Command

Ebben a megközelítésben a MI kizárólag segítségként szolgál – például olyan döntéstámogató rendszerekben, amelyek tárgyak vagy élőlények megkülönböztetésében segítik az embert.

Human-in-the-Loop

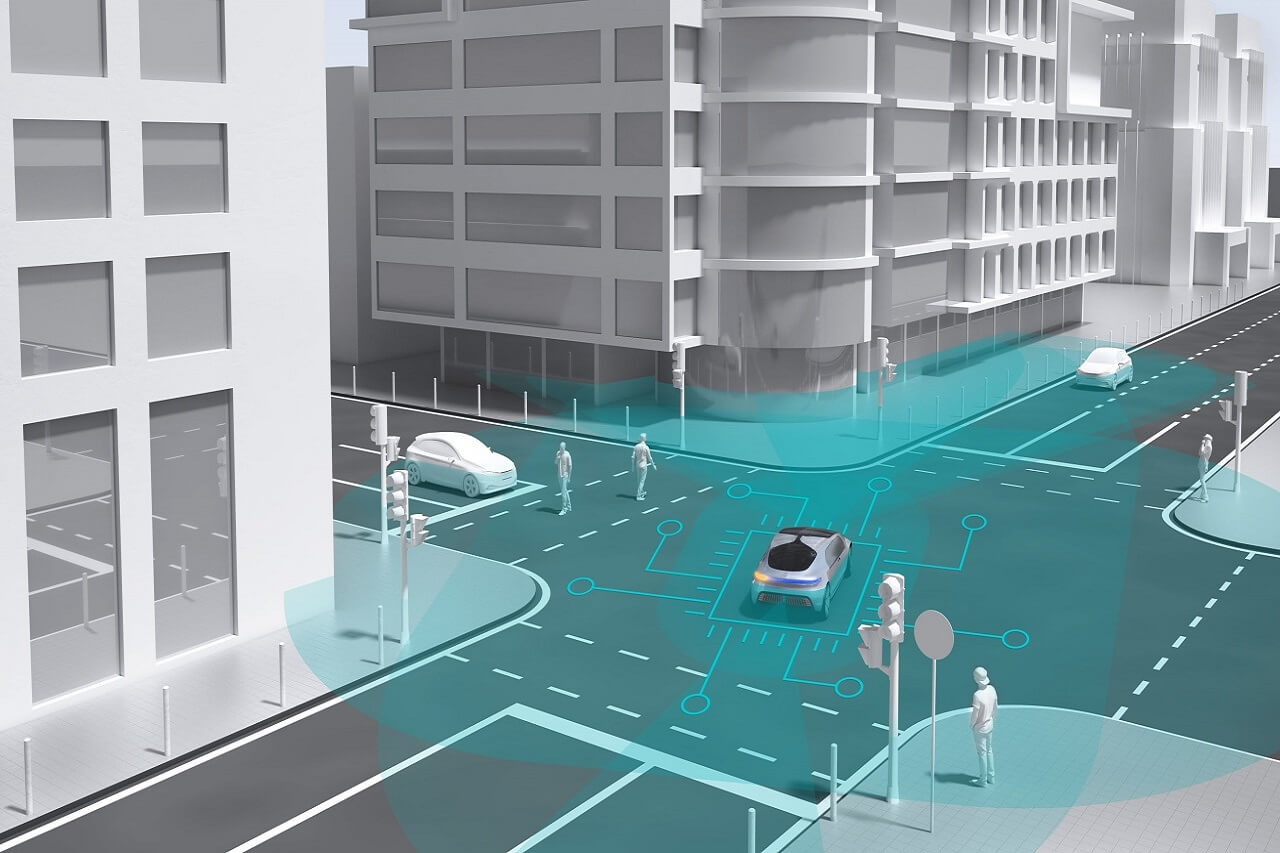

A második forgatókönyv szerint az intelligens rendszer ugyan önállóan hoz döntéseket, ám ezeket bármikor felülbírálhatja az ember. Jó példa erre a részlegesen automatizált vezetés, amikor a sofőr közvetlenül avatkozhat be az autó döntéseibe, például a parkolási asszisztens működése esetén.

Human-on-the-Loop

Ezt a megközelítést olyan intelligens alkalmazásokban használják, mint a vészfékrendszerek. A szakemberek itt bizonyos paramétereket határoznak meg a fejlesztés során, ám a döntéshozatali folyamatba nem tudnak beavatkozni. Ezek a paraméterek szolgálnak a mesterséges intelligencia azon döntéseinek alapjául, hogy adott esetben aktiválja-e a rendszert vagy sem. A fejlesztőmérnökök utólag ellenőrizhetik, hogy a gép betartotta-e a megadott paramétereket, és ha szükséges, változtathatnak rajtuk. Ez utóbbi a kulcsa az olyan negatív társadalmi hatások, mint például a diszkriminatív vagy az összeesküvéselméleteket előnyben részesítő algoritmusok féken tartásának is.